人工智能(AI)是一门探索如何使计算机模仿人类智能行为的科学。其中一个关键方面就是计算能力,也就是人工智能运算量的发展。本文将简要介绍人工智能运算量的发展史。

AI早期计算机时代(20世纪40年代-50年代)

人工智能的起源可以追溯到20世纪40年代和50年代的早期计算机时代。当时,计算机的运算速度极其有限,甚至比今天的智能手机还要慢。这限制了人工智能的发展。早期的AI研究主要集中在符号逻辑和基本规则的推理上。

20 世纪 50 年代,美国数学家克劳德·香农 (Claude Shannon) 训练了一只名为Theseus 的机器鼠,使其能够在迷宫中导航并记住其路线,这是任何类型中第一个明显的人工学习。

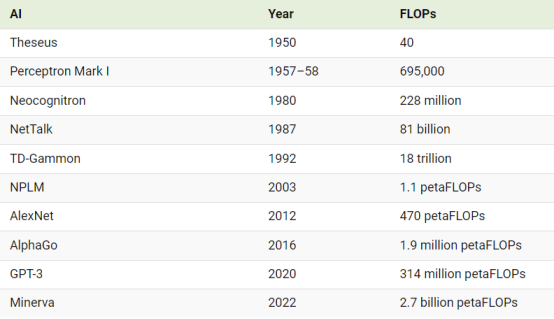

Theseus 建立在 40 个浮点运算 (FLOP) 之上,这是一种测量单位,用于计算计算机或处理器在一秒钟内可以执行的基本算术运算(加法、减法、乘法或除法)的数量。FLOP通常用作衡量计算机硬件计算性能的指标。FLOP 计数越高,计算量越高,系统就越强大。

资料来源:Sevilla 等人的“机器学习三个时代的计算趋势”。等,2022。

然而,在 2012 年 AlexNet(一种图像识别人工智能)所预示的深度学习时代开始时,随着研究人员在计算和处理器方面投入更多,翻倍的时间大大缩短至六个月。随着 2015 年 AlphaGo(一种击败人类职业围棋选手的计算机程序)的出现,研究人员确定了第三个时代:大规模人工智能模型的时代,其计算需求使之前的所有人工智能系统相形见绌。

预测AI计算进度

回顾过去十年,计算技术的发展如此之快,令人难以理解。

例如,用于训练 Minerva(一种可以解决复杂数学问题的人工智能)的计算量是10 年前用于训练 AlexNet 的计算量的近600 万倍。

以下列出了历史上重要的人工智能模型以及用于训练它们的计算量。

资料来源:Sevilla 等人的“机器学习三个时代的计算趋势”。等,2022。

运算量的成长,加上大量数据集和更好算法的出现,在看似很短的时间内取得了巨大的人工智能进步。 现在,人工智能不仅可以匹配人类的表现,而且在许多领域都超越了人类。然而,随着最近所有资金涌入人工智能,也许更多突破即将到来,例如匹配人脑的运算能力。

总之,人工智能运算量的发展史是一段不断演进的历程,从早期的计算机到GPU和云计算,再到未来的量子计算,计算能力的提升一直推动着人工智能技术的发展。这一发展历程反映了人工智能研究者不断努力提高计算资源以解决更复杂问题的决心,同时也展示了人工智能领域在不断探索和创新中的巨大潜力。